Meta prévoit d’utiliser nos données personnelles pour entrainer son IA

L’association NOYB porte plainte pour empêcher Meta d’utiliser les données personnelles de ses 400M d’utilisateurs en Europe.

Deux chercheurs de la Carnegie Mellon University avaient calculé qu’il fallait 76 jours (à raison de 8h par jour) pour lire l’intégralité des politiques de confidentialité correspondant aux services que nous utilisons en ligne sur une seule année. (McDonald, Cranor, 2012). Cette étude datant d’une dizaine d’années, il est très probable que ce chiffre soit bien supérieur aujourd’hui, d’autant plus que les mises-à-jour des politiques sont régulières et ne comportent que très rarement un résumé des modifications apportées. La nouvelle politique de confidentialité de Meta, maison mère de Facebook ne fait pas exception, et devrait rentrer en vigueur le 26 juin 2024. Heureusement pour nous, l’association NOYB (None Of Your Business) veille sur nos intérêts à travers l’activisme de son fondateur Max Schrems et de ses militants et experts en protection de la vie privée, nous permettant ainsi l’économie de 76 jours de lecture fastidieuse.

La nouvelle politique de confidentialité de Meta en violation du RGPD

Visiblement, une lecture attentive de la nouvelle politiquesde confidentialité de Meta était plus que jamais nécessaire. En effet, cette dernière vise à « ingérer de manière irréversible l’ensemble des données de plus de 400 millions de personnes concernées au sein de l’UE/EEE pour des technologies » d’intelligence artificielle » non définies, sans aucune indication quant aux finalités de ces systèmes « , indique la plainte déposée par l’association auprès de onze autorités de contrôle nationales compétentes en matière d’application du RGPD eu Europe (dont la CNIL en France).

Violant plusieurs articles du Règlement Général sur la Protection des Données (RGPD), NOYB identifie dans sa plainte six motifs principaux :

- Aucun intérêt légitime de Meta à traiter des quantités de données à caractère personnel aussi importantes pour des finalités indéterminées.

- Meta tente d’obtenir l’autorisation de traiter des données à caractère personnel pour des moyens techniques larges et non définis sans jamais préciser la finalité.

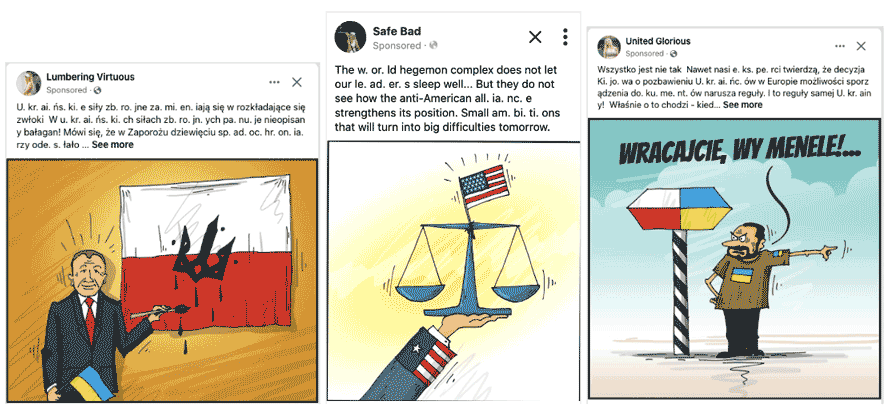

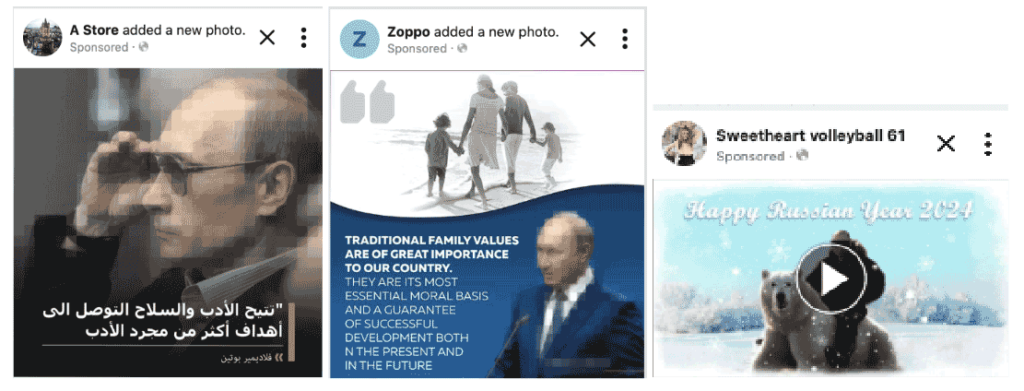

- L’utilisation par Meta de Dark Patterns considérables pour dissuader les personnes concernées d’exercer leurs droits en s’appuyant sur le droit d’opposition (opt-out) et non du consentement (opt-in).

- Meta ne fournit pas les informations nécessaires en des termes clairs et simples.

- Meta déclare ne pas être en mesure de différentier correctement (!) entre les personnes pouvant s’appuyer sur des bases légales pour traiter les données à caractère personnel et les autres.

- Enfin, Meta déclare elle-même que le traitement des données à caractère personnel est irréversible.

Utilisation massive de dark patterns par Meta – Facebook

Les Dark Patterns sont des techniques de manipulation par interface utilisateur. En passant par des schémas de navigation complexes, des étapes inutiles, des interfaces utilisateurs compliquées, les géants de la Technologie peuvent influencer grandement le comportement des utilisateurs et impacter leur capacité de jugement et de décision (voir le concept d‘ingénierie cognitive).

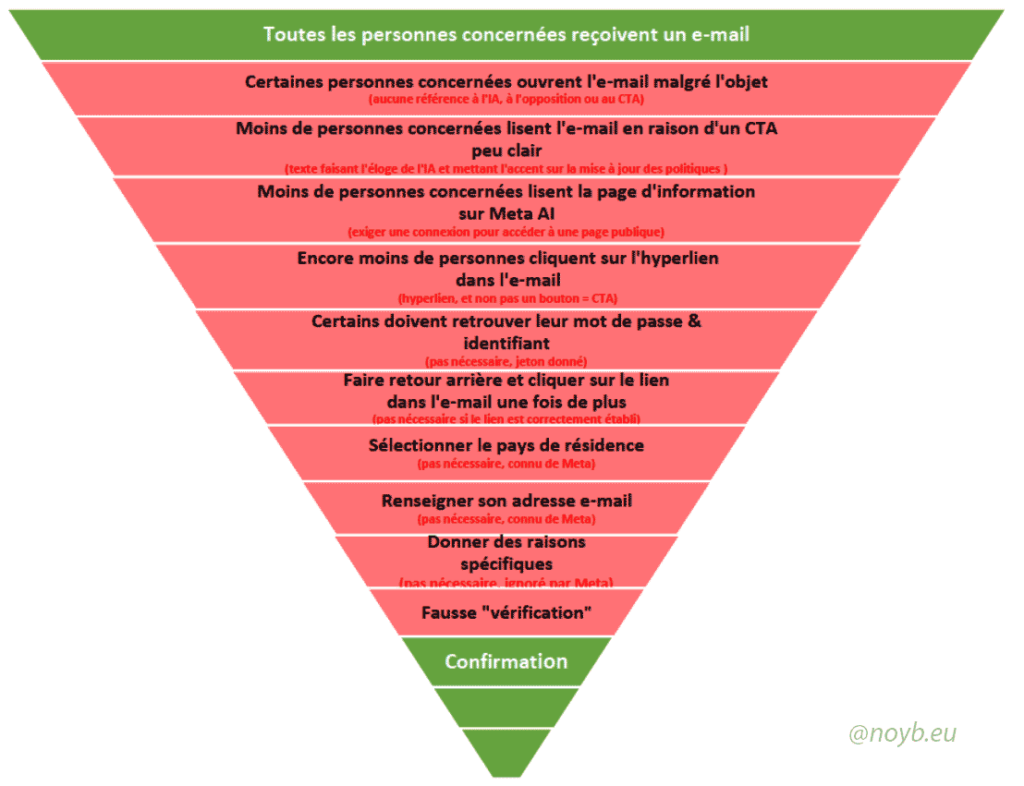

Et dans ce domaine, Meta est l’un des acteurs les plus cyniquement brillant. NOYB, dont la persévérance va bien au-delà de l’utilisateur lambda, a identifié l’introduction par Meta de pas moins de onze étapes (!) pour exercer son droit d’opposition en vertu de l’Article 21(1) du RGPD, alors que cela aurait pu être fait avec un seul bouton de désinscription.

Les différentes étapes ont été cartographiées par NOYB sous forme « d’entonnoir de conversion ». En marketing, nous avons tendance à vouloir réduire au maximum le nombre d’étapes pour minimiser les frictions et conserver une bonne expérience client. A la vue de cet entonnoir, il est évident que l’objectif de Meta est tout autre. Les étapes inutiles, ennuyeuses ou trompeuses sont indiquées en rouge.

Les recommandations de NOYB contre Facebook – Meta

En conséquence, l’association NOYB s’appuie sur le RGPD et demande aux différentes autorités compétentes de prendre les mesures urgentes suivantes:

Ça pourrait vous intéresser :

- Premièrement, d’émettre une décision d’urgence pour empêcher le traitement immanent des données personnelles de 400 millions de résidents de l’UE/EEE sans le consentement des personnes concernées.

- Deuxièmement, de mener une enquête approfondie en vertu de l’Article 58(1) du RGPD.

- Troisièmement, d’interdire l’utilisation de données à caractère personnel pour une « technologie d’intelligence artificielle » non définie sans consentement opt-in

NOYB montre une nouvelle fois toutes ces compétences juridiques, techniques et argumentaires pour documenter sa plainte et la déposer dans pas moins de onze pays européens !

De votre côté, si vous souhaitez vous opposer au traitement des données à caractère personnel vous concernant pour entrainer les modèles d’IA Facebook, j’ai bien peur qu’il ne faille suivre le douloureux process mis en place par Meta, en espérant que la plainte soit entendue et que Meta soit ainsi contraint par les autorités compétentes à revoir urgemment sa politique de confidentialité.

La dernière option étant de quitter les réseaux sociaux comme Facebook, même si cela ne constituera malheureusement pas une technique infaillible au traitement de certaines de vos données par Meta.