Affiche de propagande Russe pour encourager les citoyens à fabriquer des tanks durant la Seconde Guerre Mondiale et gagner contre l’Allemagne Nazi.

Les IA génératives actuelles sont-elles utilisées dans le cadre de campagnes de désinformation et de propagande? La propagande, écrit le sociologue Jacques Ellul, est l’ensemble des méthodes utilisées par un groupe organisé en vue de faire participer activement ou passivement à son action une masse d’individus psychologiquement unifiés par des manipulations psychologiques et encadrés par une organisation. En ce sens, les différentes campagnes de désinformation orchestrées par des groupes APT (Advanced Percistant Threat) comme le groupe Russe Doppelganger qui s’appuient sur les derniers outils d’IA génératifs constituent une nouvelle menace pour la stabilité de nos démocraties. Facebook et OpenAI jouent la transparence et publient des rapports sur l’état de la menace en ligne et les opérations d’influence.

Une opération d’influence peut être définit comme une tentative frauduleuse visant à manipuler les opinions publiques ou à influencer les décisions politiques sans révéler l’identité ou les intentions des acteurs à la manœuvre. Mais quelles influences peuvent avoir les IA génératives sur la désinformation qui opère sur Internet ?

Fin mai 2024, OpenAI publiait pour la première fois de sa jeune histoire un rapport sur l’utilisation par des acteurs malveillants de son IA générative à des fins d’opérations d’influence.

D’après ce rapport, certains acteurs malveillants utilisent les outils d’IA génératifs pour créer du contenu destiné à être partagé par des personnes ou des organisations fictives ou réelles (i.e. impersonification) ou créer des systèmes d’interactions autonomes (voir la section CounterCloud à la fin du post).

Sur les trois derniers mois, les équipes OpenAI ont ainsi identifié cinq réseaux propagandistes provenant de Russie, Chine, Iran et Israël, utilisant principalement les modèles d’IA pour produire de nombreux commentaires dans plusieurs langues en réponse à des posts sur les réseaux sociaux (X, Télégram, Facebook, Instagram, Youtube et autres sites et forums), ou encore générer et corriger de longs articles en Anglais et en Français.

On apprend également dans ce rapport qu’ OpenAI travaille en mode Red Team pour torturer ses modèles et s’assurer de la résistance de ses protections et filtres aux tentatives d’utilisations frauduleuses.

Prenons le cas de Doppelganger, acteur Russe et auteur de l’une des cinq campagnes de propagandes identifiées ces trois derniers mois par les équipes OpenAI.

Doppelganger est un acteur Russe qualifié d’acteur APT (pour Advanced Persistant Threat, ou Menaces Persistantes Avancées) dont l’objectif est de manipuler les opinions publiques au travers de campagnes de désinformation anti-Ukrainienne via les médias et les réseaux sociaux.

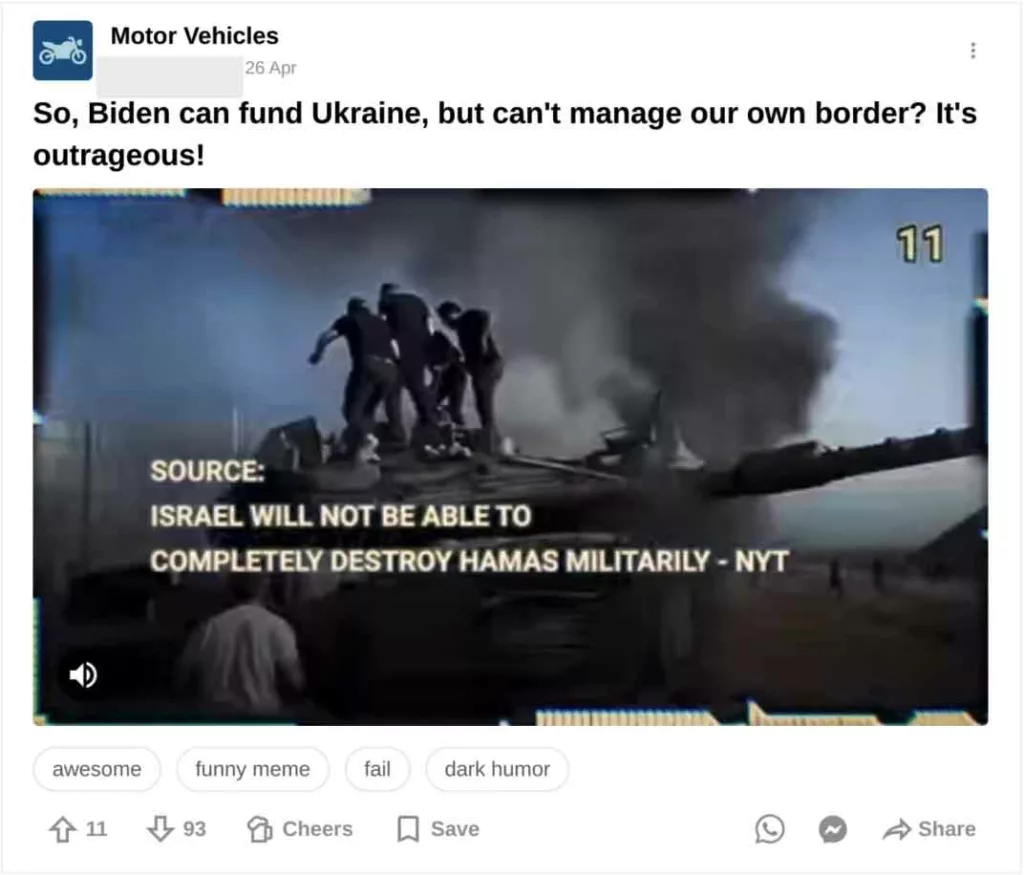

OpenAI a ainsi identifié que ses propres services avaient été utilisés pour générer des commentaires en Anglais, Français, Allemand, Italien et Polonai, postés sur le forum 9GAG et sur X/Twitter, en étant associés à d’autres liens, mèmes et vidéos. Sur 9GAG, les contenus faux ou malveillants ont été publiés dans un grand nombre de catégories dédiées aux animaux de compagnies, sports, humour et rencontres amoureuses.

Ci-dessous une des vidéos postées par un compte attribué à Doppelganger et dont le message a été écrit via l’outil d’OpenAI, ChatGPT.

A chaque fois que qu’une vidéo ou un mème sur 9GAG était posté, plusieurs comptes nouvellement créés sur la plateforme répondaient avec des messages simples comme « hahaha » ou « lol ». Le comportement de ces comptes étant assimilable à des bots (comptes nouvellement créés, aucune autre interaction sur les autres posts).

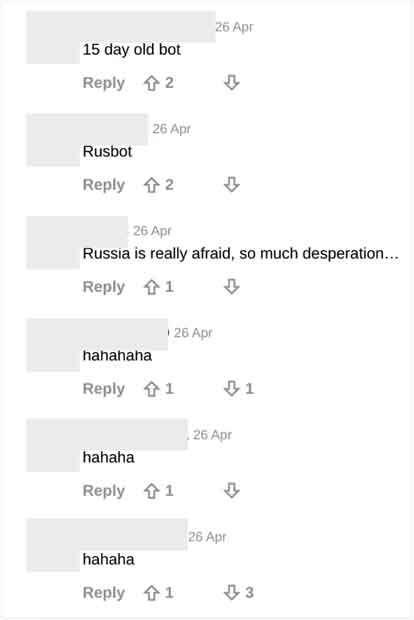

Sur le réseau X / Twitter, les commentaires étaient très souvent accompagnés d’un lien externe pointant vers des sites trompeurs comme “solarpanelfor[.]sale” ou autres sites, attribués à Doppelganger. Ces sites utilisent des restrictions géographiques limitant leurs accès à certaines IP de pays, comme l’Allemagne, l’Italie, la France, la Pologne.

Les équipes d’OpenAI ont également identifié d’autres usages comme l’utilisation de leurs services d’AI génératif pour créer et corriger des articles destinés à la communauté française et publiée sur franceeteu[.]today, site également attribué à Doppelganger.

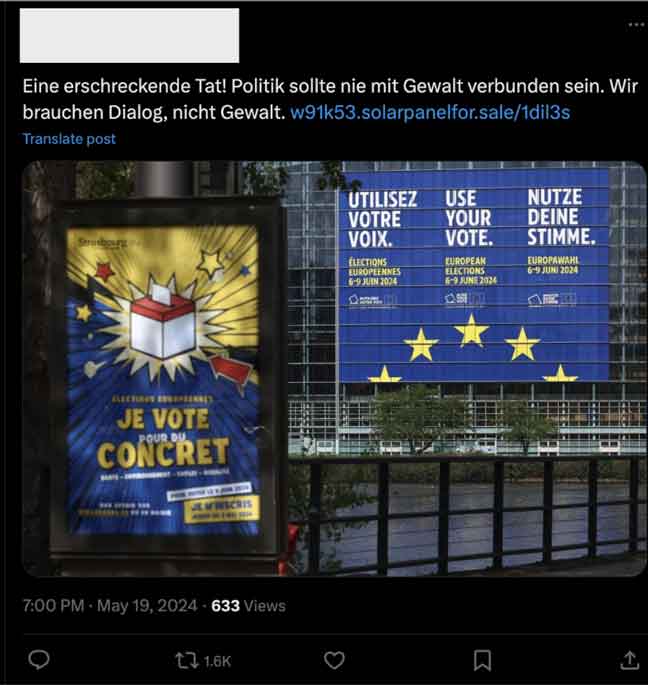

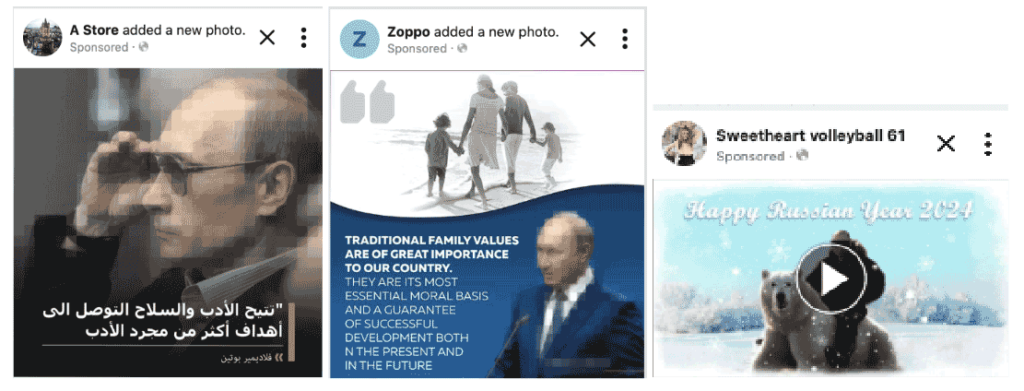

Doppelganger est également à la manœuvre sur Facebook. Dans son rapport trimestriel, la maison mère du réseau social Meta identifie six campagnes de désinformation dont une mentionne les tentatives des propagandistes russes à promouvoir les contenus de désinformation au travers notamment des outils de publicité.

On y découvre comment Doppelganger tente de détourner les systèmes de détection par mot-clef mis en place par le réseau social en créant des techniques d’obscurcissement de texte, comme la création d’espaces ou de ponctuations particulières (U. kr. ai. n. e” au lieu de “Ukraine”).

La majorité des efforts publicitaires de Doppelganger s’est tournée vers du contenu pro-russe et ne cachant pas ses objectifs de critique des Ukrainiens et des alliés dans le contexte de la guerre. La propagande ne s’est pas limitée à la zone Europe / Amérique du Nord. Ci-dessous des publicités ayant ciblé les audiences Algériennes, Pakistanaises et Indiennes.

Dans son rapport, Meta n’indique cependant pas quel contenu en lien avec les campagnes de désinformation Russes a pu être généré par IA. Nous pouvons légitimement penser que certains contenus produits par les IA génératives se retrouvent sur l’ensemble des plateformes de réseaux sociaux, y compris Facebook comme le mentionne OpenAI dans son rapport.

A la lumière de ces rapports, nous ne pouvons que souligner les efforts de transparence des plateformes Meta et OpenAI qui semblent réaliser le formidable potentiel de nuisance que peuvent constituer les outils qu’ils mettent à disposition des utilisateurs du monde entier.

Il est encourageant de voir que l’un des principaux acteurs de l’IA aujourd’hui se saisisse de la question en publiant son premier rapport et propose notamment de fermer chaque compte impliqué dans la création de contenu de désinformation.

Meta dans son rapport encourage les gouvernements, chercheurs et entreprises de technologies à travailler de manière collaborative et à échanger sur l’état de la menace, notamment dans le cadre des campagnes de propagandes comme celles activées par la Russie.

Il est important de noter que dans les onze campagnes analysées par OpenAI (cinq) et Facebook (six), aucune ne semble avoir eu un impact significatif sur les audiences des plateformes. La création de contenus efficaces via les outils d’IA génératifs ne semblent pas suffisants pour assurer la viralité. Le porteur du message qui en assure la diffusion est clef. C’est là ou la stratégie du gouvernement chinois de travailler avec des influenceurs authentiques semble payante. En bénéficiant d’audiences larges, les influenceurs génèrent des engagements importants via leurs communautés qui poussent avec enthousiasme les éléments de langage du PCC et le narratif officiel qui semblent bien plus efficaces que les fakes générés par l’IA (pour aller plus loin, voir « ingénierie cognitive« ).

L’effort de transparence des plateformes doit être salué. Cependant, il est impératif que les chercheurs et les institutions puissent avoir accès à plus de données afin de pouvoir analyser les propagations et tentatives de manipulation et confirmer ou infirmer les dires des acteurs technologiques. Meta à travers son Influence Operations Research Archive permet déjà d’étudier certaines données mettant en lumière des récits narratifs alternatifs et des comportements qui vont au delà des résumés proposés par les rapports des plateformes. Il est également critique que le régulateur puisse s’appuyer sur ces données et sur les chercheurs (via l’audit des algorithmes) pour comprendre comment fonctionnent les plateformes et les systèmes de détection et de régulation, afin de proposer des réglementations pertinentes.

Je vous propose de terminer cet article avec un petit bonus, le projet CounterCloud. Projet absolument passionnant. A défaut de rassurer, il nous alerte sur les risques et propose des pistes de remédiations.

Le projet CounterCloud a consisté à produire un système de propagande 100% automatisé et autonome géré par des IA, le tout pour $400.

Dans cette expérimentation, les chercheurs ont réussi à générer des articles de presse contradictoires, des tweets, à inventer des journalistes fictifs et des sites en utilisant ChatGPT de OpenAI et d’autres modèles d’IA en open source.

Nea Paw, l’auteur du projet a souhaité alerter sur les risques faisant peser les IA génératives sur la production en masse de contenu de désinformation.

Je vous propose de découvrir le projet en vidéo. A voir absolument :